NYHET

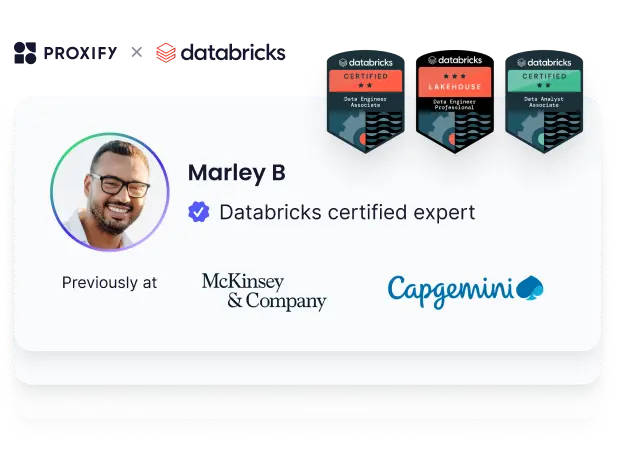

Proxify er åpen om utviklerens prestasjoner — det er bransjeledende, og også enhver CTOs drøm.

Finn ut mer

Databricks, som er kjent for sin avanserte analyse og evne til å behandle stordata, er en dynamisk plattform som styrker både utviklere og dataforskere.

La oss dykke ned i det viktigste for å bygge et stjerneteam som kan navigere og trives i Databricks' fartsfylte verden.

Forstå Databricks

Databricks tilbyr tilgang til mange datakilder og integrasjon med Apache Spark.

Fleksibiliteten og tilpasningsmulighetene gjør det mulig å skape et bredt spekter av løsninger, fra strømlinjeformede verktøy til innovasjoner på bedriftsnivå. Med teknologier som Delta Lake og MLflow forbedrer Databricks effektiviteten ytterligere, og legger til rette for sømløs datahåndtering og arbeidsflyter for maskinlæring.

Databricks utmerker seg innen databehandling med høy ytelse og sanntidsanalyse, og utnytter Apache Sparks distribuerte databehandlingskapasitet. Den enhetlige plattformen forenkler utvikling på tvers av bransjer, noe som gjør den til et ideelt valg for organisasjoner som søker skalerbare løsninger.

Trender som datasjøer og AI-konvergens former utviklingen, og Databricks ligger fortsatt i forkant når det gjelder innovasjon innen datahåndtering og analyse.

Databricks fortsetter å dominere det globale markedet for stordata og analyse, og nye trender som integrering av kunstig intelligens og maskinlæring, sammen med økt fokus på datasikkerhet, er med på å forme det fremtidige landskapet. Med sin dedikasjon til innovasjon og tilpasningsevne er Databricks klar til å lede an i arbeidet med å revolusjonere datadrevne løsninger i årene som kommer.

Bransjer og bruksområder

Databricks har bruksområder i en rekke bransjer, blant annet finans, helse, detaljhandel og telekommunikasjon. Allsidigheten ligger i at det kan håndtere ulike datakilder, alt fra strukturerte databaser til ustrukturerte data som tekst og bilder.

En rekke selskaper bruker Databricks til oppgaver som prediktiv analyse, databehandling i sanntid og anbefalingssystemer. Den skybaserte arkitekturen gjør den til et smart valg for bedrifter som søker skalerbare og kostnadseffektive løsninger for sine stordatautfordringer.

Må-ha tekniske ferdigheter for Databricks-utviklere

Visse tekniske ferdigheter er ikke forhandlingsbare når vi ansetter Databricks-utviklere. Disse grunnleggende ferdighetene gjør det mulig for utviklerne å bruke Databricks-plattformen effektivt og sikre at de kan drive dataprosjektene dine sømløst fra idé til gjennomføring.

- Kompetanse i Apache Spark: En sterk forståelse av Apache Spark er avgjørende ettersom Databricks i stor grad er avhengig av Spark for databehandling og analyse.

- Spark SQL: Kunnskap om Spark SQL er avgjørende for å kunne spørre og manipulere data i Databricks-miljøer.

- Python- eller Scala-programmering: Kompetanse i enten Python, R eller Scala er nødvendig for å utvikle egendefinerte funksjoner og implementere datapipelines.

- Datateknikk: Ekspertise i datatekniske prinsipper, inkludert datamodellering, ETL-prosesser og datalagringskonsepter, er grunnleggende for å utforme effektive datapipelines.

- Skyplattform: Kjennskap til skyplattformer som AWS, Azure eller Google Cloud er avgjørende for å kunne distribuere og administrere Databricks-klynger.

Gode å ha tekniske ferdigheter

Noen ferdigheter er essensielle, mens andre kan forbedre en Databricks-utviklers evner og tilpasningsevne, slik at teamet ditt ligger i forkant når det gjelder innovasjon og effektivitet. Noen av disse ferdighetene inkluderer:

- Maskinlæring og AI: Erfaring med maskinlæring algoritmer og AI teknikker kan forbedre en utviklers evne til å bygge prediktive modeller og utnytte avanserte analysefunksjoner i Databricks.

- Teknologier for strømprosessering: Kunnskap om rammeverk for strømprosessering som Apache Kafka eller Apache Flink kan være nyttig for å implementere løsninger for databehandling i sanntid.

- Containerisering og orkestrering: Forståelse av containeriseringsverktøy som Docker og orkestreringsplattformer som Kubernetes kan gjøre det lettere å distribuere og administrere Databricks-miljøer i containeriserte arkitekturer.

Intervjuspørsmål og svar

1. Forklar konseptet med lat evaluering i Apache Spark. Hvordan kommer det Databricks-brukere til gode?

Eksempel på svar: Lazy evaluation i Apache Spark refererer til optimaliseringsteknikken der Spark utsetter utførelsen av transformasjoner til det er absolutt nødvendig. Dette gjør det mulig for Spark å optimalisere kjøringsplanen ved å kombinere flere transformasjoner og utføre dem sammen, noe som reduserer omkostningene ved å flytte data mellom noder. I Databricks resulterer dette i mer effektiv ressursutnyttelse og raskere kjøring av spørringer.

2. Hva er fordelene og ulempene ved å bruke Delta Lake i Databricks sammenlignet med tradisjonelle datasjøer?

Eksempel på svar: Delta Lake tilbyr flere fordeler i forhold til tradisjonelle datasjøer, for eksempel ACID-transaksjoner, skjemahåndhevelse og tidsreisefunksjoner. Det medfører imidlertid også ekstra kostnader i forbindelse med lagring og behandling.

3. Hvordan håndterer Databricks skjemautvikling i Delta Lake?

Eksempel på svar: Databricks Delta Lake håndterer skjemautvikling gjennom skjemahåndhevelse og skjemautviklingsfunksjoner. Skjemahåndhevelse sikrer at alle data som skrives til Delta Lake, er i samsvar med det forhåndsdefinerte skjemaet, og forhindrer skjemakonflikter. Skjemautvikling gjør det mulig å utvikle skjemaet automatisk for å ta hensyn til nye kolonner eller datatyper uten at det kreves eksplisitte skjemauppdateringer.

4. Hvilke forskjellige sammenføyningsstrategier er tilgjengelige i Spark SQL, og hvordan optimaliserer Databricks sammenføyningsoperasjoner?

Eksempel på svar: Spark SQL støtter ulike sammenføyningsstrategier, inkludert broadcast hash join, shuffle hash join og sort-merge join. Databricks optimaliserer sammenkoblingsoperasjoner ved å analysere størrelsen på datasettene, fordelingen av data på tvers av partisjoner og tilgjengelige minneressurser for å velge den mest effektive sammenkoblingsstrategien dynamisk.

5. Beskriv prosessen med å optimalisere Apache Spark-jobber for ytelse i Databricks.

Eksempel på svar: Optimalisering av Apache Spark-jobber i Databricks innebærer flere trinn, inkludert effektiv partisjonering av data, hurtigbufring av mellomresultater, minimering av stokking, utnyttelse av kringkastingsvariabler og innstilling av konfigurasjoner som kjøringsminne, stokkingspartisjoner og parallellisme.

6. Forklar konseptet lineage i Databricks Delta Lake og dets betydning for datastyring og sporing av lineage.

Eksempel på svar: Lineage i Databricks Delta Lake refererer til den historiske oversikten over datatransformasjoner og operasjoner som er brukt på et datasett. Det er avgjørende for datastyring, ettersom det gir innsyn i hvordan data transformeres og brukes, noe som muliggjør sporbarhet, revisjon og overholdelse av lovpålagte krav.

7. Hvordan håndterer Databricks skjevhet i Apache Spark-applikasjoner, og hvilke teknikker kan brukes for å redusere den?

Eksempel på svar: Databricks benytter ulike teknikker for å håndtere skjevhet i data, for eksempel beskjæring av partisjoner, dynamisk partisjonering og optimalisering av skjeve sammenføyninger. I tillegg kan teknikker som datareplikering, salting og manuell håndtering av skjevheter gjennom tilpasset partisjonering bidra til å redusere problemer med skjeve data i Spark-applikasjoner.

8. Forklar forskjellen mellom RDD-er (Resilient Distributed Datasets) og DataFrames i Apache Spark. Når ville du valgt den ene fremfor den andre i Databricks?

Eksempel på svar: RDD-er er den grunnleggende dataabstraksjonen i Spark, og tilbyr transformasjoner og handlinger på lavt nivå, mens DataFrames gir et API på høyere nivå med strukturerte databehandlingsfunksjoner og optimaliseringer. I Databricks er RDD-er å foretrekke for komplekse, tilpassede transformasjoner eller når det kreves finkornet kontroll over databehandlingen, mens DataFrames egner seg for de fleste strukturerte databehandlingsoppgaver på grunn av sin enkelhet og optimaliseringsmuligheter.

9. Hva er de kritiske funksjonene i Delta Engine, og hvordan forbedrer den ytelsen i Databricks?

Eksempel på svar: Delta Engine i Databricks er en spørringsmotor med høy ytelse som er optimalisert for Delta Lake. Den tilbyr funksjoner som adaptiv spørringskjøring, vektorisert spørringsbehandling og GPU-akselerasjon. Det forbedrer ytelsen ved å optimalisere kjøringsplanene for spørringer basert på datastatistikk, minnetilgjengelighet og maskinvarekapasitet, noe som resulterer i raskere behandling av spørringer og bedre ressursutnyttelse.

10. Hvordan støtter Databricks sanntids strømmebehandling med Apache Spark Structured Streaming? Beskriv arkitekturen og de viktigste komponentene som er involvert.

Eksempel på svar: Databricks støtter strømmebehandling i sanntid med Apache Spark Structured Streaming, som utnytter en mikrobatchbehandlingsmodell med kontinuerlige prosesseringsfunksjoner. Arkitekturen omfatter komponenter som en strømmekilde (f.eks. Apache Kafka), Spark Structured Streaming-motoren og senker for lagring av behandlede data (f.eks. Delta Lake, eksterne databaser).

11. Diskuter utfordringene med å håndtere store datamengder i Databricks, og hvordan du vil løse dem.

Eksempel på svar: Håndtering av store datamengder i Databricks byr på utfordringer knyttet til datainnhenting, lagring, behandling og ytelsesoptimalisering. For å løse disse utfordringene vil jeg bruke datapartisjonering, distribuert databehandling, caching, optimalisering av lagringsformater og avanserte funksjoner som Delta Lake og Delta Engine for effektiv datahåndtering og -behandling.

12. Beskriv prosessen med å migrere lokale arbeidsbelastninger til Databricks. Hvilke hensyn og beste praksis bør følges?

Eksempel på svar: Migrering av lokale arbeidsbelastninger til Databricks innebærer vurdering av eksisterende arbeidsbelastninger og avhengigheter, utforming av en arkitektur som er optimalisert for Databricks, migrering av data og kode, testing og validering av migreringen og optimalisering av ytelsen etter migreringen. Beste praksis omfatter utnyttelse av Databricks-funksjoner for datahåndtering, optimalisering av ressursutnyttelse og overvåking av ytelse.

13. Hvordan støtter Databricks maskinlæring og AI-arbeidsflyter? Diskuter integrasjonen med populære ML-rammeverk og -biblioteker.

Eksempel på svar: Databricks tilbyr en enhetlig plattform for maskinlæring og AI-arbeidsflyter, og tilbyr integrasjon med populære ML-rammeverk og biblioteker som TensorFlow, PyTorch, Scikit-learn og MLflow. Det muliggjør sømløs datapreparering, modelltrening, hyperparameterinnstilling og distribusjon gjennom samarbeidende notatbøker, automatiserte rørledninger og modellregisterfunksjoner, noe som gjør det enklere å administrere ML-livssyklusen fra start til slutt.

Sammendrag

Å ansette de rette talentene til Databricks-roller er avgjørende for å kunne utnytte alle mulighetene i denne dynamiske plattformen. Ved å fokusere på de viktigste tekniske ferdighetene sikrer du at teamet ditt har ekspertisen som trengs for å administrere og optimalisere dataarbeidsflyten på en effektiv måte.

Ved å inneha disse viktige ferdighetene og holde seg oppdatert på de nyeste fremskrittene innen stordatateknologi, kan Databricks-utviklere bidra effektivt til teamene sine og drive frem innovasjon i datadrevne beslutningsprosesser.

Når du går videre med ansettelsesprosessen, må du huske at organisasjonens styrke ligger i medarbeiderne. Med det rette teamet kan du åpne opp for nye muligheter og drive organisasjonen din til nye høyder av suksess i en verden av stordata og analyse.